Soweit ist klar, dass die Settings von den Stimmen, Mikros, Aufnahmesituation und gewünschte Atmosphäre abhängig sind.

Ich geb’ es aber nicht auf, dass wir einen General-Fit wie die Loudness-Taste finden können, der für viele eine Verbesserung darstellt, wenn sie sich nicht weiter damit beschäftigen wollen. Und im Gegensatz zur Taste will ich die dynamische Veränderung zum Ausgleich der Fletcher-Munson curves zur Vereinfachung noch außen vor lassen.

Vielleicht müssen wir die Frage nur anders angehen: Welches Ergebnis empfinden wir als angenehm?

Um sich nicht ein Einzelheiten zu verlieren, konzentriere ich mich auf den 5er-EQ mit den Bereichen 0-100Hz, 100-500Hz, 500Hz-2.5kHz, 2.5kHz-4kHz und 4kHz-22kHz- diese Bereiche meine ich auch bei Rob Williams im Hinweis von @Joey wiederzuentdecken.

Ein Verstärken oder Dämpfen in den Bereichen wirkt sich direkt auf die darin enthaltene Schallenergie aus, die gewünschte Verteilung sollte also durch das Verhältnis der Energielevel zueinander charakterisiert werden können.

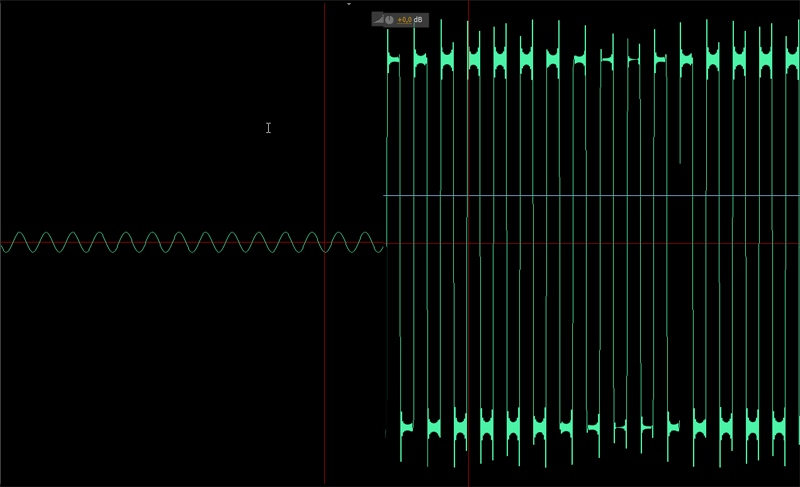

Ich habe dazu in ospac gestern abend einen Analyzer hinzugefügt, der diese Energieverteilung in aktiven Bereichen eines Kanals bestimmt. (Die Verteilung ist L2-normiert, d.h. die Quadrate der Werte summieren sich auf 1 bzw. der 5-dimensionale Vektor hat die Länge 1. Die Ausgabe multipliziert die Werte mit 100.)

Bei meiner Testdatei im Repository erhalte ich die Verteilung (15,92,23,5,27).

Diese möchte ich nun einer Zielverteilung anpassen- dafür brauche ich einen nicht zu langen und nicht zu kurzen Beispiel-Monolog. Ich habe mir mal die ME002 und ME003 als Vorlage genommen. Das soll jetzt keine Wertung sein- es war nur mein erster Einfall und offensichtlich klingt das anders.

Die Ergebnisse waren zwar zwischen den beiden sehr ähnlich, doch auch überraschend. Hier ein Beispiel (ME002): (30,91,27,3,9). Hier ist also der Bereich 0-100Hz deutlich angehoben, sowie der Bereich 4kHz-22kHz deutlich geringer (evtl. durch den Tiefpass bei der MP3 komprimierten Variante, die ich als Vorlage nahm).

Wenn ich nun per Hand den Equalizer in ospac darauf anpasse (wenn das Verfahren Sinn macht, kann man das ja automatisieren), also in diesem Fall u.a. 0-100Hz anhebe (!) und 4-22kHz senke, erhalten ich meinen Empfinden nach tatsächlich einen angenäherten Klang, der sich nicht künstlich anhört. Der Energievektor lautet jetzt (30,90,27,4,13)- das trifft nicht genau, da ich bei der Analyse nur aktive Passagen berücksichtige, der Equalizer aber auf alles läuft und sich dadurch ändert, was als aktiv erachtet wird und was nicht.

Statt also feste EQ-Settings vorzugeben, könnte es funktionieren, einen Zielvektor zu definieren.

Welche Frauen- und Männerstimmen findet ihr in Monologen gut ausgemischt, die ich mal durch den Analyzer schicken könnte? (Am besten 1-10min Folgen mit nur einer Stimme ohne Musik.) Oder bin ich da auf dem Holzweg?