Klar, so ein „Menschen-lesbares“ Format kommt natürlich auch!

Das liegt an Apple, kann mir aber schwer vorstellen dass sie ihre Spracherkennung nach außen öffnen.

Klar, so ein „Menschen-lesbares“ Format kommt natürlich auch!

Das liegt an Apple, kann mir aber schwer vorstellen dass sie ihre Spracherkennung nach außen öffnen.

Ich habe letztens auch mal ein wenig mit Spracherkennung rum gespielt und habe dafür die Bing Speech API benutzt. Ich habe die allerdings nicht direkt mit den anderen Services verglichen, das Ergebnis war aber ganz in Ordnung.

@ubahnverleih Danke für den Hinweis.

Wir haben die Bing API auch integriert, sie hat aber immer viel schlechtere Ergebnisse als die anderen Services geliefert (zumindest auf Deutsch und Englisch) und war auch noch komplizierter zum Einrichten.

Keine Ahnung wie das in anderen Sprachen aussieht.

Falls es Bedarf daran gibt und sie zumindest irgendeinen Vorteil hat (vielleicht haben wir ihn ja auch einfach noch nicht gesehen), schalten wir diese gerne frei!

Der einzige Vorteil war, dass es mehr Freivolumen gab als bei Google. Ja es ist tatsächlich schwierig da die richtigen API-Keys zu finden.

@ubahnverleih Ja, Wit.ai ist aber im Gegensatz zu bing komplett kostenfrei und war auch von der Qualität her in den vergangenen Tests immer besser.

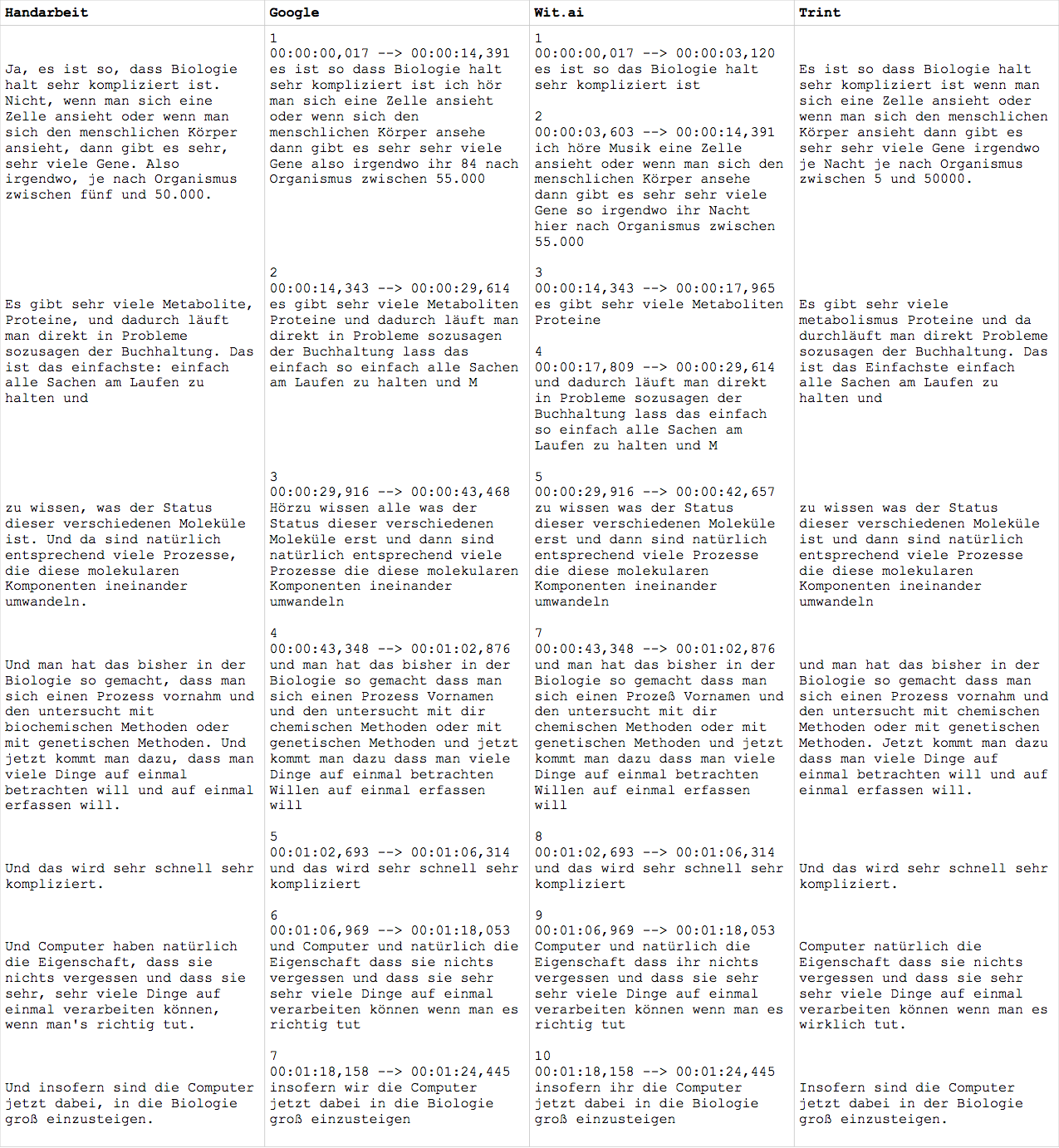

Oben habe ich mal einen Vergleich zu Siri aufgestellt: Spracherkennung für Podcasts - #24 von Wilhelm

Die Mac Spracherkennung liefert ganz gute Ergebnisse, vllt. kann man die Spuren irgendwie in die Mac-Spracherkennung auf dem Desktop hinein-pipen … ![]() Man muüsste die Datei ja eig. nur als Spracheingabe in Software (über ein Softwaredivce …?) deklarieren und dann die Sprachausgabe in eine Textdatei schreiben, quasi das Gegenteil von

Man muüsste die Datei ja eig. nur als Spracheingabe in Software (über ein Softwaredivce …?) deklarieren und dann die Sprachausgabe in eine Textdatei schreiben, quasi das Gegenteil von

`say MEIN TOLLER TEXT -o „~/Dateipfad/Dateiname-test.aiff“

Vielleicht kann man sowas in @auphonic esktop App einbauen? ![]()

`

Keine Ahnung ob sowas geht - wenn ja dann ist das sicher eine interessante Option!

Ja, das kannst du mit den USH-Devices, den virtuellen Soundkarten von Ultraschall machen. Z.B. in Ultraschall das fragliche Audio auf das Aux-Device routen und dann in den Mac-Systemeinstellungen unter Diktat Aux als Quelle einstellen.

Ich meine irgendwo gelesen zu haben, dass sich die Mac-Diktatfunktion nach und nach auf die eigene Stimme einstellt. Deshalb war ich zurückhaltend damit, das mit Interviews auszuprobieren.

Hier gibt’s die Luxusvariante:

Funktioniert auch sehr gut und kann sogar ein wenig Interpunktion:

In iOS 10 gibt es eine API für Speech Recognition. Soweit ich das verstanden habe, ist sie aber nur für sporadische Requests ausgelegt und auf maximal eine Minute Audio pro Request limitiert.

Danke für den Tipp!

So wie ich das sehe hat https://trint.com/ einen schönen Editor gebaut, jedoch nicht du Spracherkennung selbst entwickelt (schätze mal die verwenden auch Google).

Oder weiß hier jemand mehr darüber?

Hat sich mal jemand angeschaut ob man die Apple Speech Recognition auch lokal aus einem macOS per Python ansprechen kann?

hate ich auch schon mal angeregt.

Was funktioniert, mehr schlecht als recht: Wenn man über ein Interface den Ton einspielt und dann in ein Textverarbeitungsprogramm einfüllt.

Konkret:

Audiospur auf’s iPhone geschoben, dann folgende Kette

iPhone -> 3.5mm Kabel (male - male) -> Zoom Line-In -> Zoom USB an Mac -> über Reaper geroutet -> über "Dikatetfunktion" (fn fn drücken, oder Menü > Bearbeiten > Diktat starten) in Audio eingefügt.

Wenn man ein sauberes Audio hat, geht das. Aber, was viel störender ist, ist dass keinerlei Interpunktion gegeben wird.

Hier wird wohl an einer Open-Source-Spracherkennung auf Basis von Tensorflow gearbeitet: https://github.com/pannous/tensorflow-speech-recognition

Es gibt eine gute Open Source Spracherkennungssysteme (z.B. kaldi).

Das Problem sind in diesem Bereich aber eher die Daten, nicht der “Source” - deshalb helfen einen diese Open Source Systeme halt leider auch nicht viel …

Siehe auch #subscribe8: Spracherkennung für Podcasts

Wie komme ich denn an die komplette Transkription bei Wit.ai? Ich sehe kurze Häppchen, die ich dann trainieren soll, aber es sollte doch irgendwo eine Datei mit dem kompletten Text geben, oder? (SRT?)

Die Transkription sieht du auch der Auphonic Resultatseite.

Schick mir sonst bitte mal den Link zu deiner Production, dann kann ich mir das ansehen!

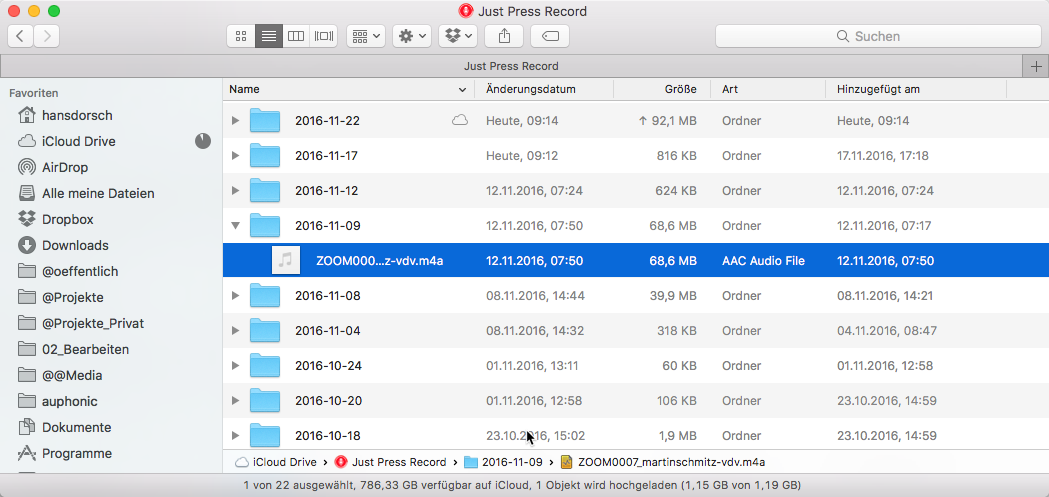

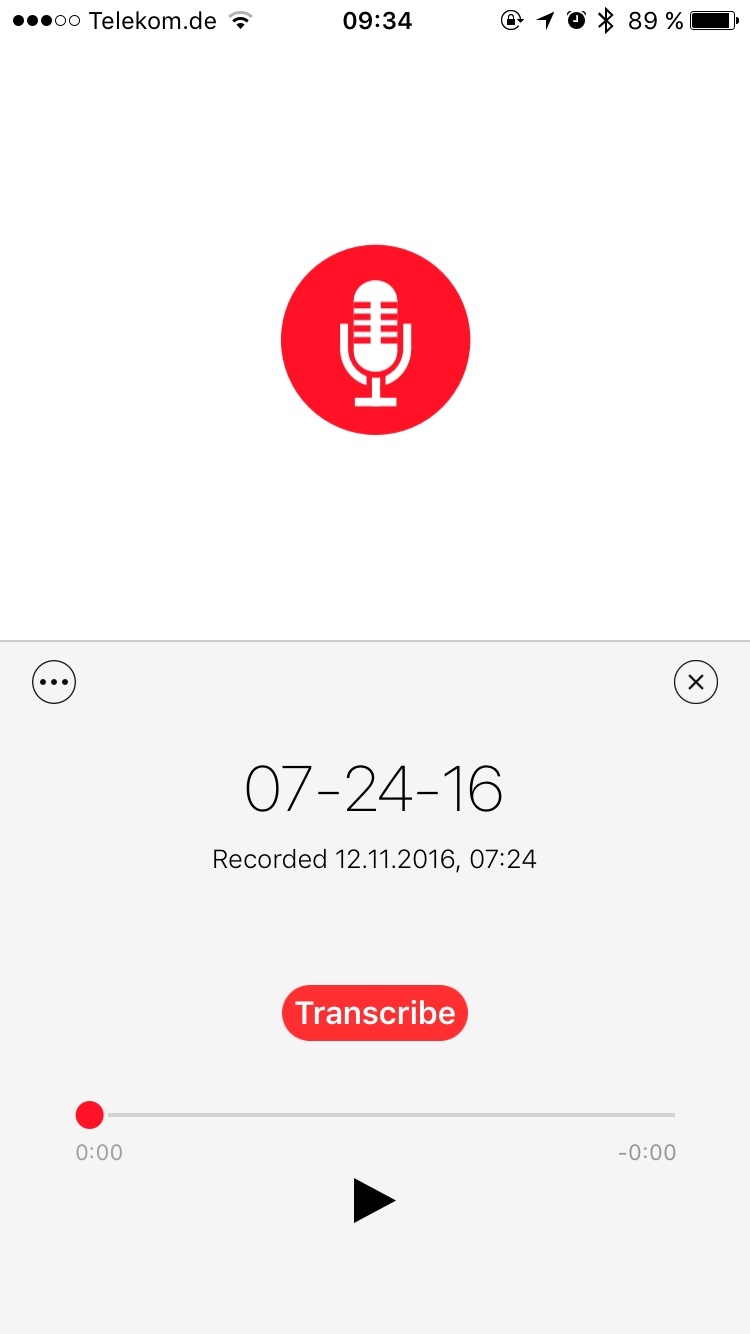

Noch ein Tipp für iOS und Apple-Nutzer: Die App Just Press Record nutzt die iOS 10 Spracherkennungs-API. Du kannst direkt aufnehmen, aber auch Audiodateien in den iCloud-Ordner legen.

Die Transkription kannst du dann auf dem iPhone starten. Die funktioniert in Echtzeit, aber die App muss im Vordergrund sein. Ich überprüfe gerade, welche Formate erkannt werden.

Das sieht dann so aus:

Ich bin gespannt auf deine Tests.