Hallo zusammen,

in Vorbereitung auf die anstehende SUBSCRIBE 18 in Köln habe ich mich gefragt, was ich zur Community beitragen könnte. Ich selbst arbeite schon seit einer ganzen Weile im Big Data und Data Science Umfeld, hab also mäßigen Plan, was Machine Learning & Co. angeht.

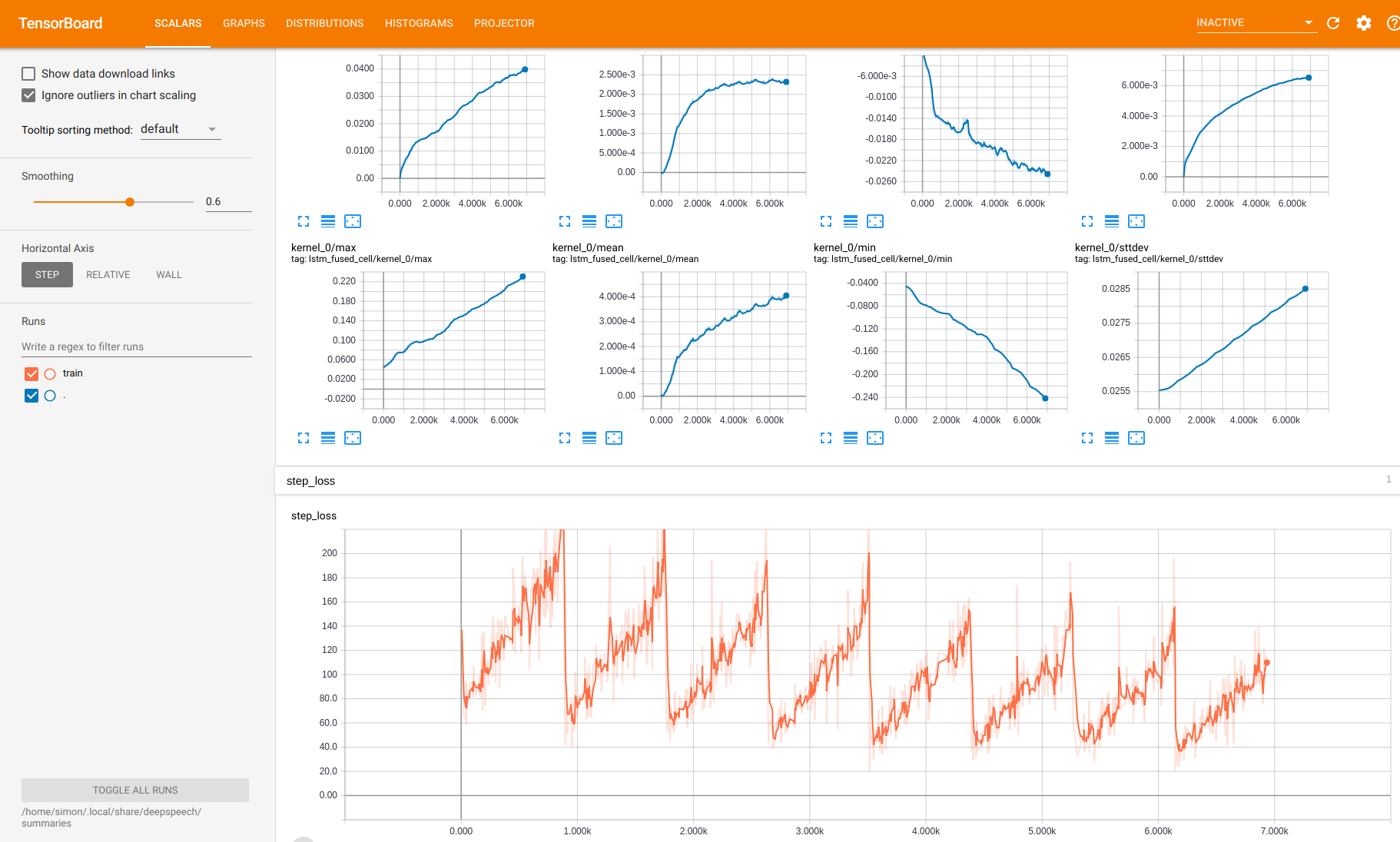

Nun ist mir aufgefallen, dass das “Wie bekommen wir Audio-Transkipte halbwegs automatisiert?”-Problem noch nicht gelöst ist. Weiterhin ist mir aufgefallen, dass Mozilla gerade an einer Open Source Speech-To-Text-Engine arbeitet (DeepSpeech: https://github.com/mozilla/DeepSpeech)

Außerdem hat Mozilla das Common Voices Projekt, welches einen entsprechenden Datensatz zum Erstellen eines Machine Learning Modells erzeugen soll, auch seit letztem Jahr auf die Sprache “Deutsch” ausgeweitet (Common Voices: https://voice.mozilla.org/de)

Frage: Hat schon jemand mal mit DeepSpeech experimentiert/Erfahrung gesammelt?

Idee: Wenn man es hin bekäme, einen entsprechend großen deutschen Datensatz zu erzeugen, könnte man ein deutsches Modell auf Basis von DeepSpeech erzeugen, welches man vielleicht mit jeder Ultraschall-Installation gleich mitliefert. Dann müsste man entsprechende Bindings von Reaper/Ultraschall bereitstellen, um das Modell anzusprechen. In Reaper/Ultraschall bräuchte man dann ein Script, welches jede Audiospur einzeln in kleine Teile mit max. 5 Sekunden Länge zerhackt, dann gegen das Modell wirft, dann das Ergebnis in eine Datei mit dem Timecode wirft. Das macht man dann per Audiospur einzeln, damit man kein “zwischengelaber” hat, womit das Modell sicher nicht klar käme. Zum Schluss müsste man die einzelnen Files/Timecodes noch mergen und eine einzige Datei erzeugen, die man dann irgendwo hin schreibt, damit der Kram dann weiter in den Podlove Publisher reinfließen kann.

Der deutsche Common Voice Datensatz ist aktuell nicht unfassbar groß, aber da man als Podcaster ja sowieso stark unter “Rededrang” leidet und wir alle entsprechendes Aufnahme-Equipment vorliegen haben, könnte man schon mal als Community-Projekt mit entsprechenden Daten beliefern. Den Rest müsste man sich dann halt mal ansehen.

Was meint ihr dazu? Klingt das aus eurer Sicht sinnvoll?