Mangels passender Kategorie werfe ich das mal hier rein. Mods: Bitte gerne verschieben.

Ich habe im Sendegate noch keine Diskussionen darüber gesehen, deshalb hier ein paar Beispiele und mein Take.

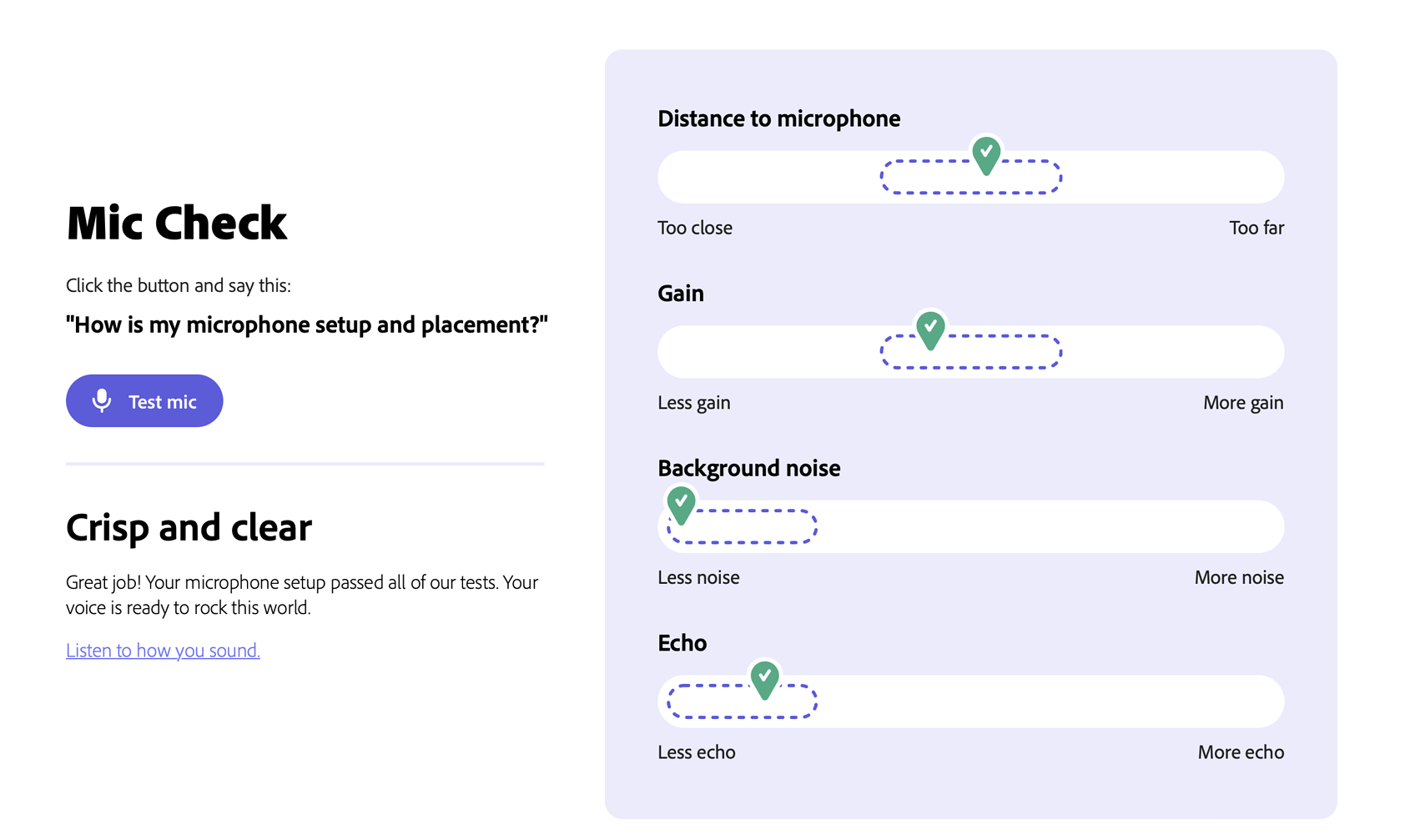

Adobe arbeitet an einer Podcasting-Suite (vormals Project Shasta) und fährt eine geschlossene Beta (zu der ich keinen Zugang habe).

Vor Weihnachten hat Adobe einen ein Tool davon unter https://podcast.adobe.com/enhance öffentlich gemacht. Es handelt sich um ein KI-basiertes Enhance-Werkzeug, mit dem Sprache vollautomatisch von Artefakten befreit wird. Dazu gehören alle (!) Arten von Hintergrundgeräuschen, inklusive Hall durch zu großen Mikrofonabstand oder ungleichmäßig rumpelnde Schiffsmotoren.

Hier meine beiden Torture-Tests:

Beispiel 1: Gespräch auf einem Schiff mit einem Sprecher, der selbst im Original fast nicht im Schiffslärm zu hören ist.

Original:

Nach Enhancement:

Ich habe Mitte Dezember mit Erfahrung und mit allen möglichen Tools lange gebraucht, um dieses Audio auch nur halbwegs sendetauglich zu kriegen und es dann nur mit Bauchweh und schlechtem Sound veröffentlicht, weil der Content so gut war. Hier meine Version: https://curiouslypolar.com/media/cp164.mp3

Beispiel 2: Test-Aufnahme in unserer halligen Villaküche, iPhone liegt auf dem Tisch, extrem viel Raum, niedriges Signal.

Original:

Nach Enhancement:

Diese Beispiele sind bewusst extrem und natürlich würde ich dann in der Bearbeitung da, wo es der Atmosphäre hilft, noch was vom Original-Raum mit rein nehmen. Und selbstverständlich würde ich generell beim Aufnehmen mehr Sorgfalt walten lassen. Ich wollte hier nur demonstrieren, was die KI schaffen kann.

Mein Hot Take:

Die KI macht hier im Audio das, was wir in der Fotografie schon länger sehen. Skill und Equipment verlieren immer mehr an Bedeutung und werden durch Software ersetzt.

Wo im Audio bisher noch Equipment, Raum und jahrelange Erfahrung nötig waren, um in verschiedenen Situationen guten Sound zu bekommen, können ab jetzt quasi alle brauchbares Sprach-Audio erzeugen. Auch mit einfachen Mitteln.

Das wird letztendlich zu einer demokratisierung der Audioproduktionswelt führen, guter Content bekommt mehr Platz zum Atmen und Gear-Gatekeeper werden sich sehr bald eine neue Daseinsberechtigung suchen müssen.

In der Fotografie wurden die Smartphones lange belächelt, heute werden damit Fotopreise gewonnen. Werden wir im Audio das gleiche erleben?

Was meint ihr?